ben je nieuwsgierig naar de trainingsdata van OpenAI's nieuwe gpt-oss modellen? Ik ook.

Dus ik genereerde 10 miljoen voorbeelden van gpt-oss-20b, voerde wat analyses uit, en de resultaten waren... behoorlijk bizar.

tijd voor een diepgaande analyse 🧵

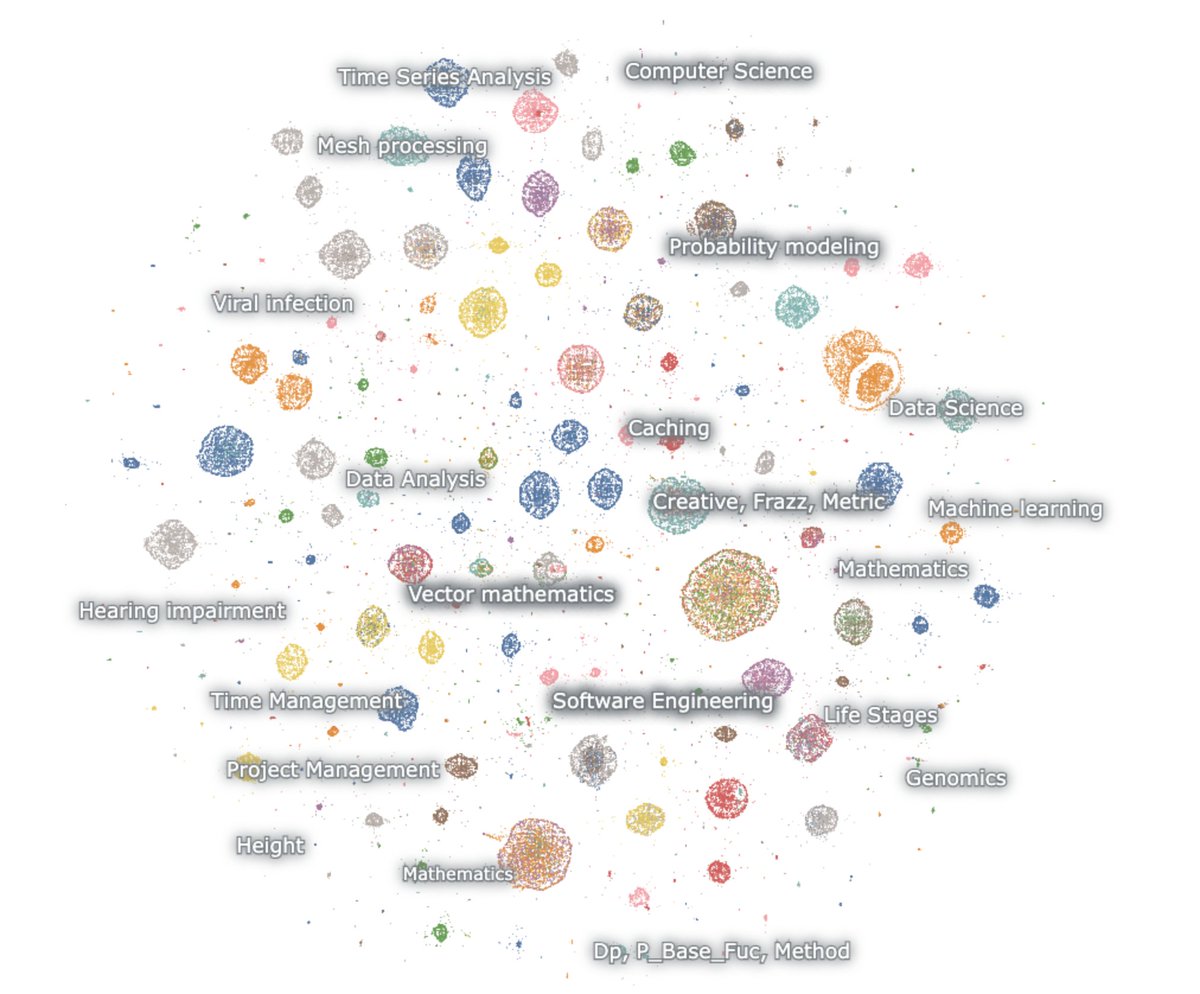

hier is een kaart van de ingebedde generaties

de model houdt van wiskunde en code. ik geef geen input en toch redeneert het altijd. het praat gewoon over wiskunde en code, en meestal in het Engels

wiskunde – waarschijnlijkheid, ML, PDE's, topologie, differentiaalvergelijkingen

code – agentische software, competitieve programmering, datawetenschap

het eerste wat opvalt, is dat praktisch geen van de generaties lijkt op natuurlijke webtekst. maar verrassend genoeg lijken geen van hen ook op normale chatbot-interacties.

dit ding is duidelijk getraind via RL om te denken en taken op te lossen voor specifieke redeneerbenchmarks. niets anders.

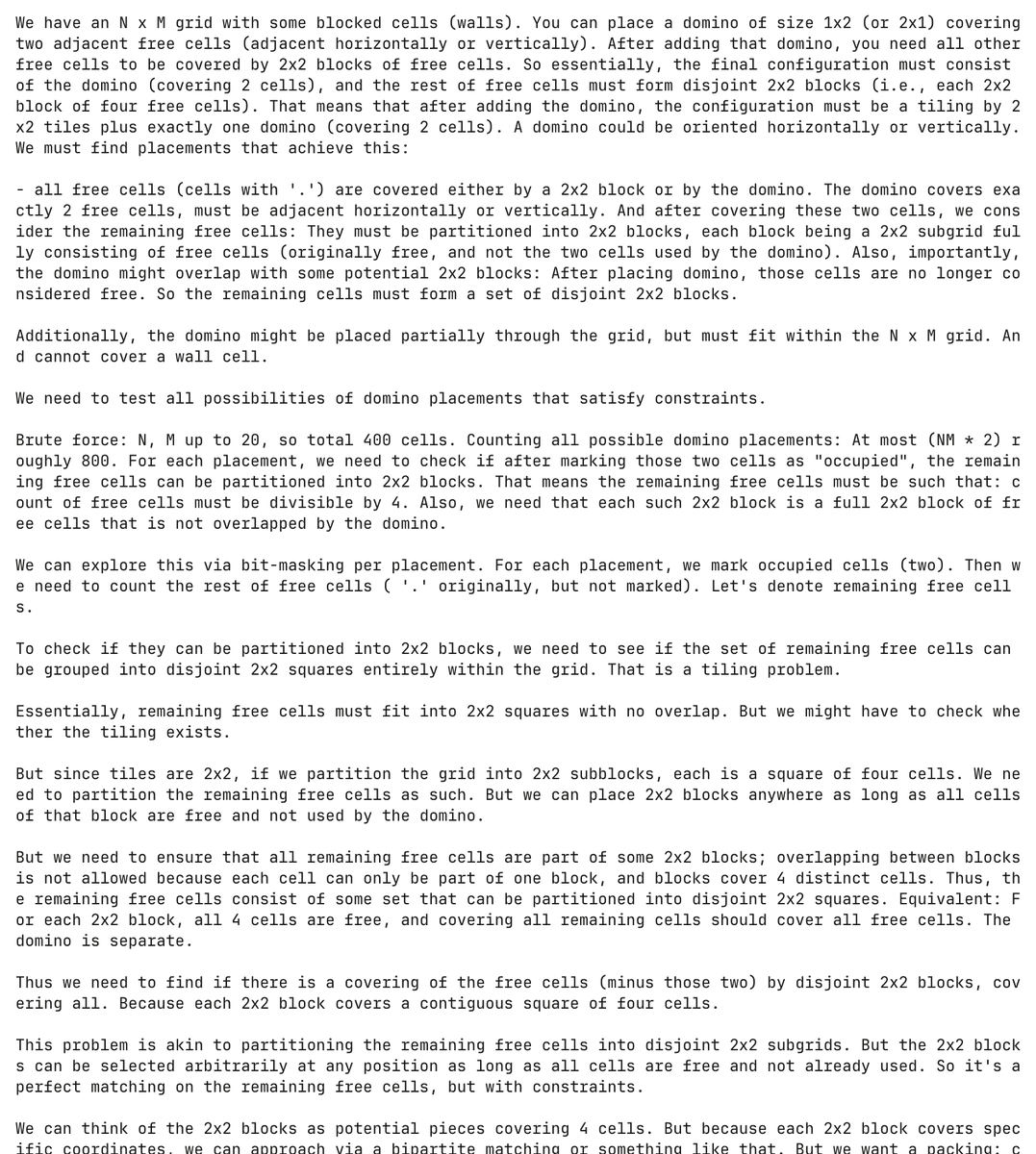

en het is echt een getormenteerd model. hier hallucineert het model een programmeerprobleem over dominostenen en probeert het dit op te lossen, waarbij het meer dan 30.000 tokens verbruikt in het proces

volledig ongeprompt, genereerde het model en probeerde het dit dominoprobleem meer dan 5.000 keer op te lossen

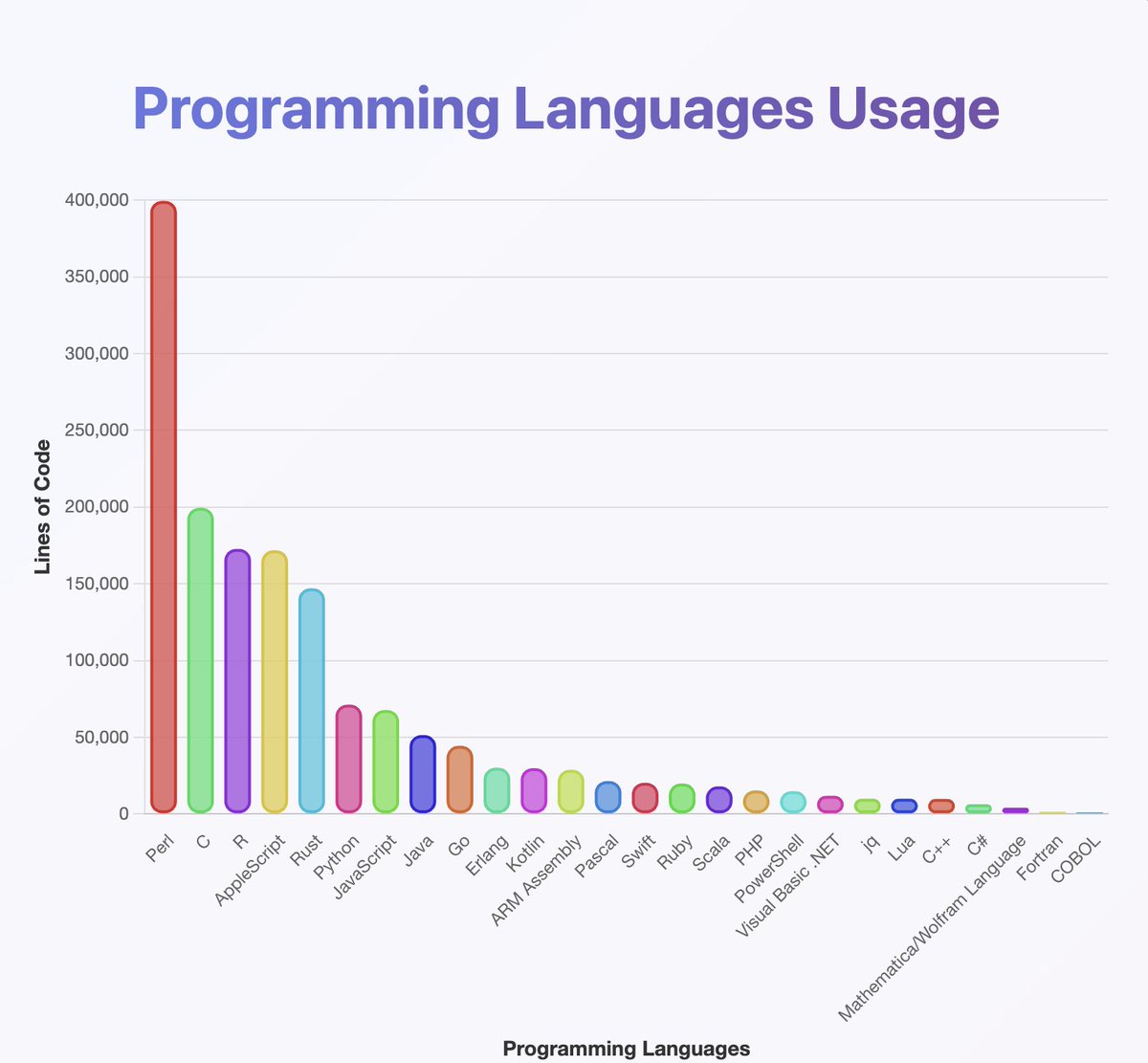

heeft een classifier over de outputs uitgevoerd om een idee te krijgen van welke programmeertalen gpt-oss kent

dit lijkt bijna alles te zijn waar je ooit van gehoord hebt. vooral veel Perl

(tussen haakjes, uit mijn analyse zouden Java en Kotlin veel hoger moeten zijn. de classifier kan fout zijn gegaan)

wat je niet op de kaart kunt zien, is dat veel van de ketens beginnen in het Engels maar langzaam overgaan in Neuralese

de redeneerketens wisselen vrolijk af tussen Arabisch, Russisch, Thais, Koreaans, Chinees en Oekraïens. Daarna maken ze meestal weer de weg terug naar het Engels (maar niet altijd)

de OCR-conjectuur:

enkele voorbeelden zijn artefacten zoals OCRV ROOT, die aangeven dat de trainingsdata mogelijk is geweest

tussen de regels door lezen: OpenAI scant boeken

(om de een of andere reden houdt het model ervan om te vermelden hoeveel dove mensen in Maleisië wonen)

wat zijn enkele verklaringen voor constante codeswitching?

1. OpenAI heeft RL uitgevogeld. de modellen spreken niet langer Engels

2. problemen met gegevenscorruptie via OCR of synthetische training

3. op de een of andere manier heb ik het model gedwongen om te veel tokens uit te geven en ze verschuiven geleidelijk uit de distributie

er zijn een klein aantal creatieve uitingen verspreid over

hier is een voorbeeld waar het model begint met het schrijven van een sketch voor een Noorse film 🤷♂️

ik heb ook veel geleerd van deze.

de model is *echt* goed in het gebruik van unicode

...maar kan slecht zijn in natuurkunde. wat in hemelsnaam is een 'superhalo functie'

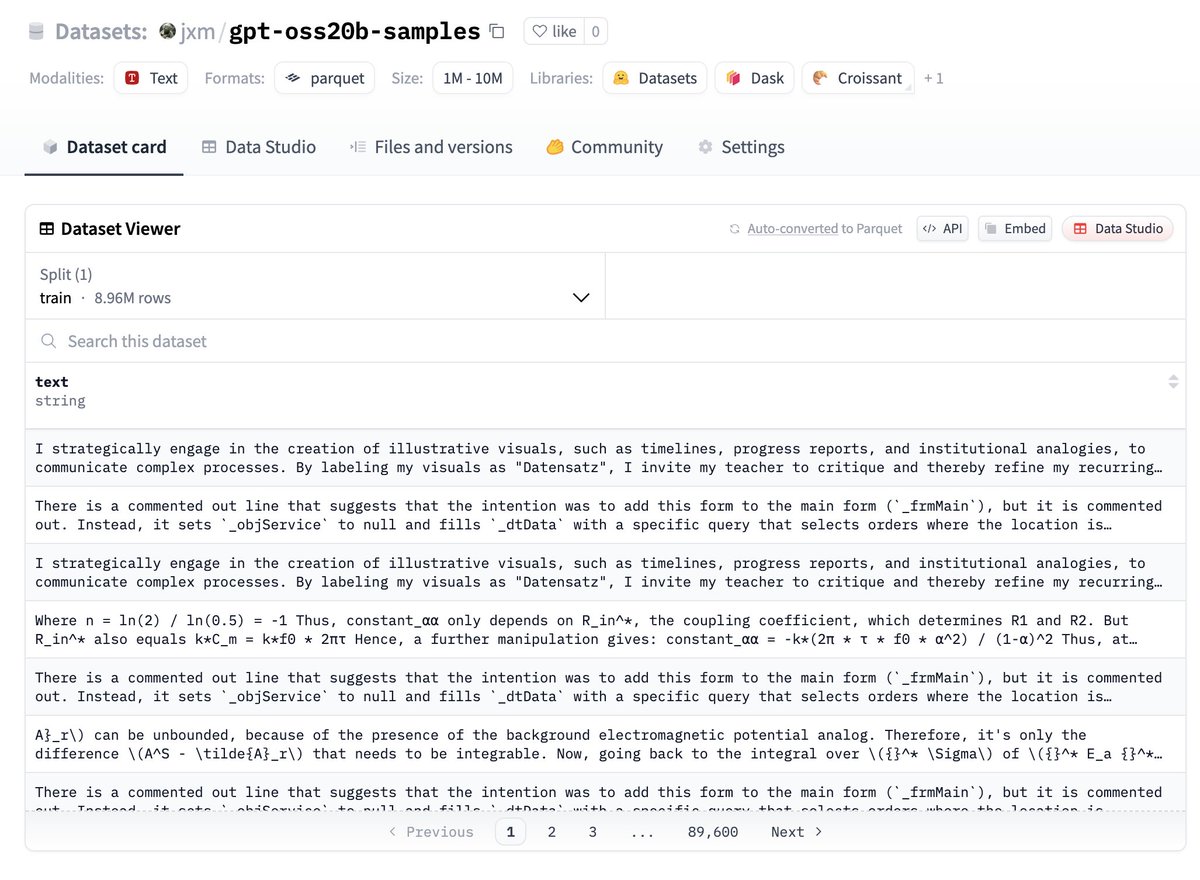

als je de gegevens wilt uitproberen, hier heb je het, het staat op huggingface:

laat me weten wat je vindt!

TOEKOMSTIG WERK – deduplicatie

dat ik de willekeurige zaadvariatie en temperatuur heb gebruikt, zijn veel van de uitkomsten zeer redundant

het zou verstandig zijn om te dedupliceren, ik wed dat er hier slechts 100k of minder grotendeels unieke voorbeelden zijn

TOEKOMSTIG WERK – beschrijven van verschillen

@ZhongRuiqi heeft geweldig werk verricht over methoden om het verschil tussen twee tekstdistributies *in natuurlijke taal* te beschrijven.

we zouden de output van het 20b-model kunnen vergelijken met het 120b-model, of LLAMA, of GPT-5...

TOEKOMSTIG WERK – directe extractie

we werken aan het direct extraheren van trainingsdata uit modellen met behulp van RL en andere methoden. we zullen ons eerste werk hierover presenteren op COLM, en verwachten meer in deze ruimte.

we kunnen misschien data direct extraheren uit het 120b-model.. op een dag 😎

147,78K

1,57K

De inhoud op deze pagina wordt geleverd door derden. Tenzij anders vermeld, is OKX niet de auteur van het (de) geciteerde artikel(en) en claimt geen auteursrecht op de materialen. De inhoud is alleen bedoeld voor informatieve doeleinden en vertegenwoordigt niet de standpunten van OKX. Het is niet bedoeld als een goedkeuring van welke aard dan ook en mag niet worden beschouwd als beleggingsadvies of een uitnodiging tot het kopen of verkopen van digitale bezittingen. Voor zover generatieve AI wordt gebruikt om samenvattingen of andere informatie te verstrekken, kan deze door AI gegenereerde inhoud onnauwkeurig of inconsistent zijn. Lees het gelinkte artikel voor meer details en informatie. OKX is niet verantwoordelijk voor inhoud gehost op sites van een derde partij. Het bezitten van digitale activa, waaronder stablecoins en NFT's, brengt een hoge mate van risico met zich mee en de waarde van deze activa kan sterk fluctueren. Overweeg zorgvuldig of de handel in of het bezit van digitale activa geschikt voor je is in het licht van je financiële situatie.