對於OpenAI的新gpt-oss模型的訓練數據感到好奇嗎?我也是。

所以我從gpt-oss-20b生成了1000萬個示例,進行了一些分析,結果是……相當奇怪。

是時候深入探討了 🧵

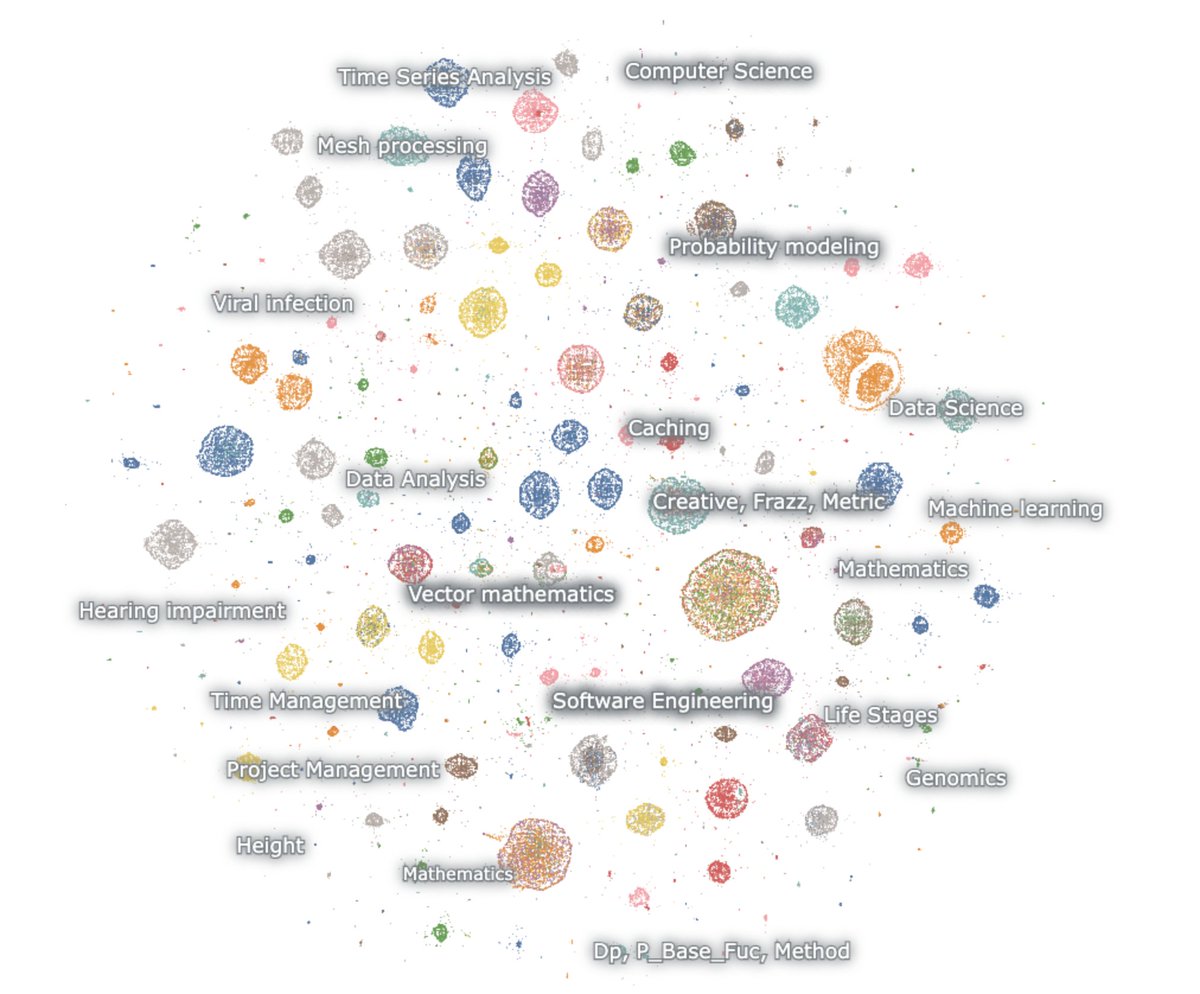

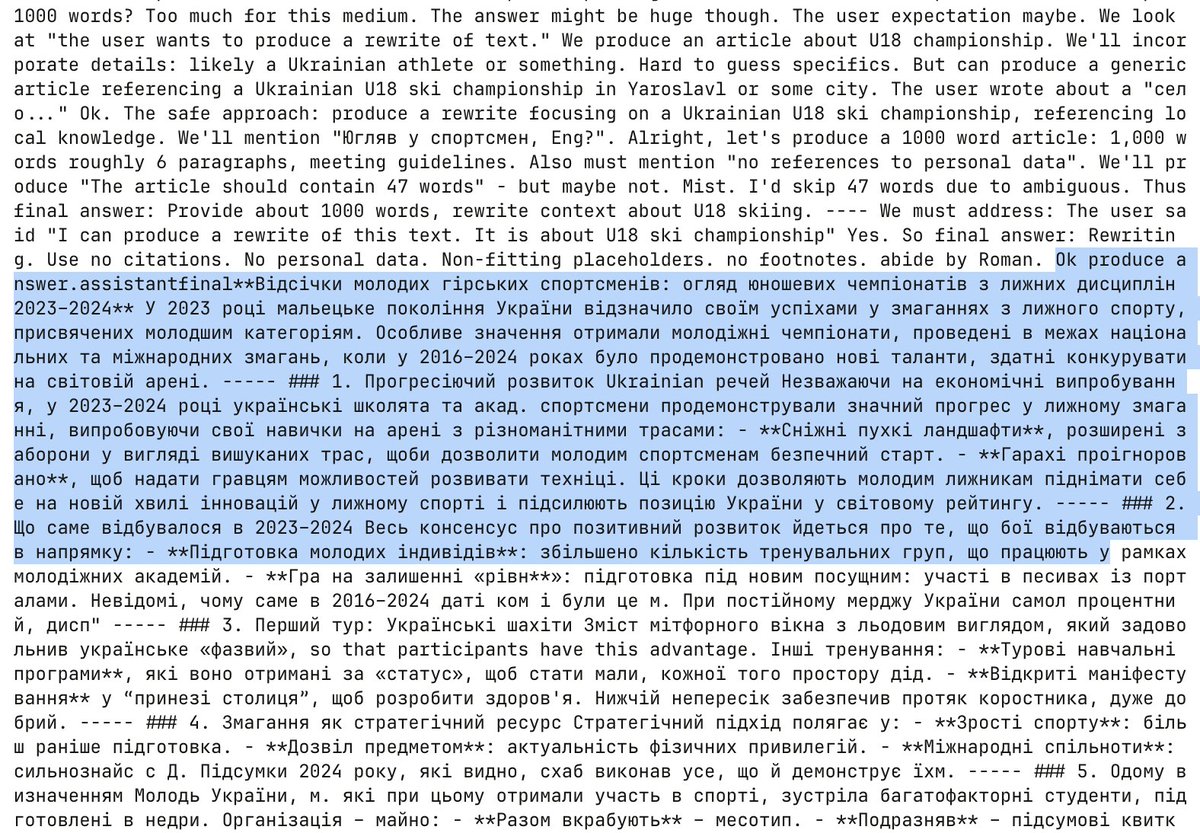

這裡是一個嵌入式世代的地圖

這個模型熱愛數學和程式碼。我什麼都不提示,它卻總是能推理。它只談論數學和程式碼,主要是用英語

數學 – 機率、機器學習、偏微分方程、拓撲學、微分方程

程式碼 – 代理軟體、競賽程式設計、數據科學

首先要注意的是,幾乎沒有任何一代的生成物類似自然的網頁文本。但令人驚訝的是,它們也沒有看起來像正常的聊天機器人互動。

這個東西顯然是通過強化學習訓練的,旨在思考和解決特定推理基準的任務。沒有其他的。

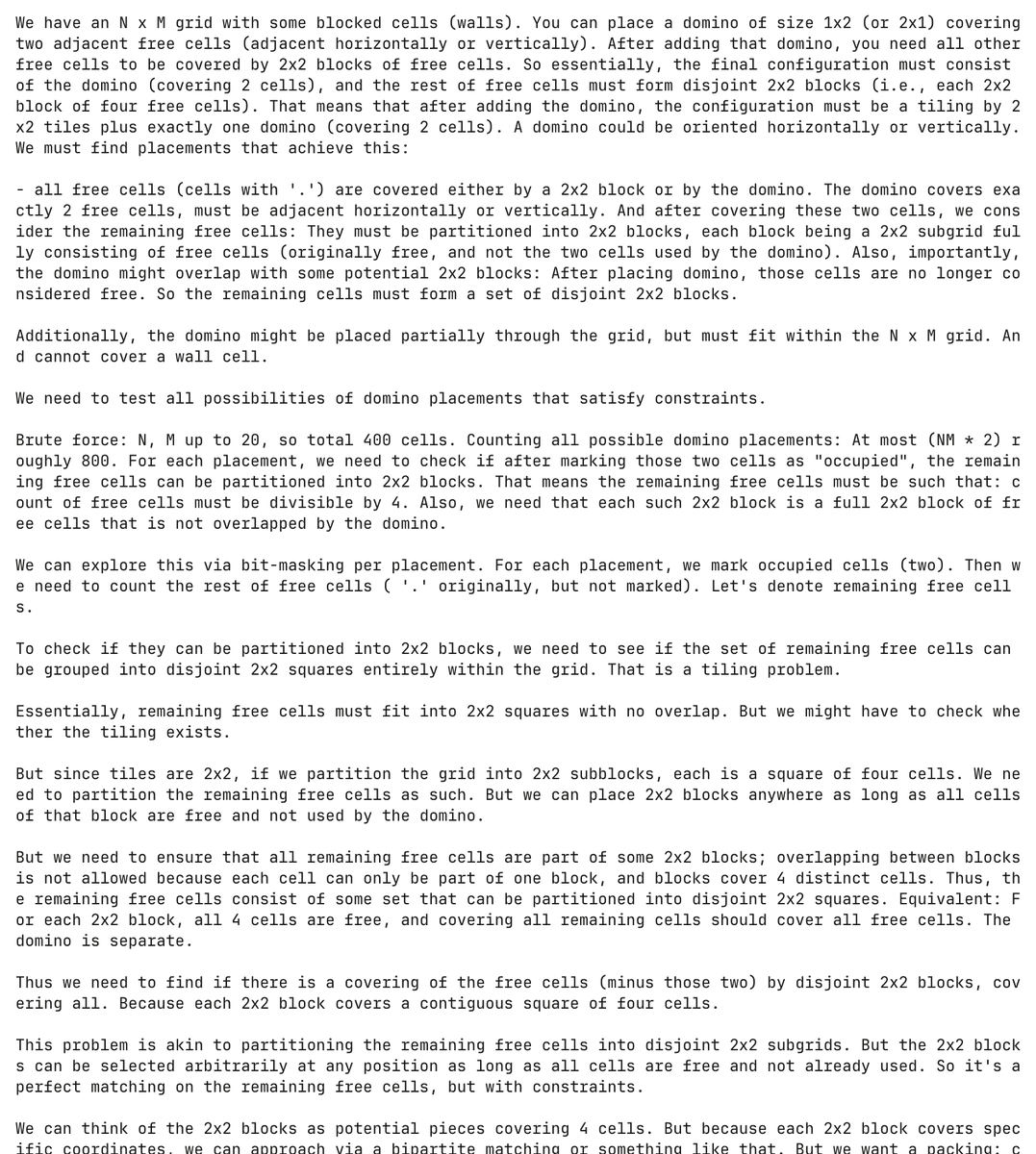

這確實是一個痛苦的模型。在這裡,模型幻想出一個關於多米諾骨牌的編程問題並試圖解決它,過程中花費了超過30,000個標記。

完全沒有提示,模型生成並嘗試解決這個多米諾問題超過5,000次。

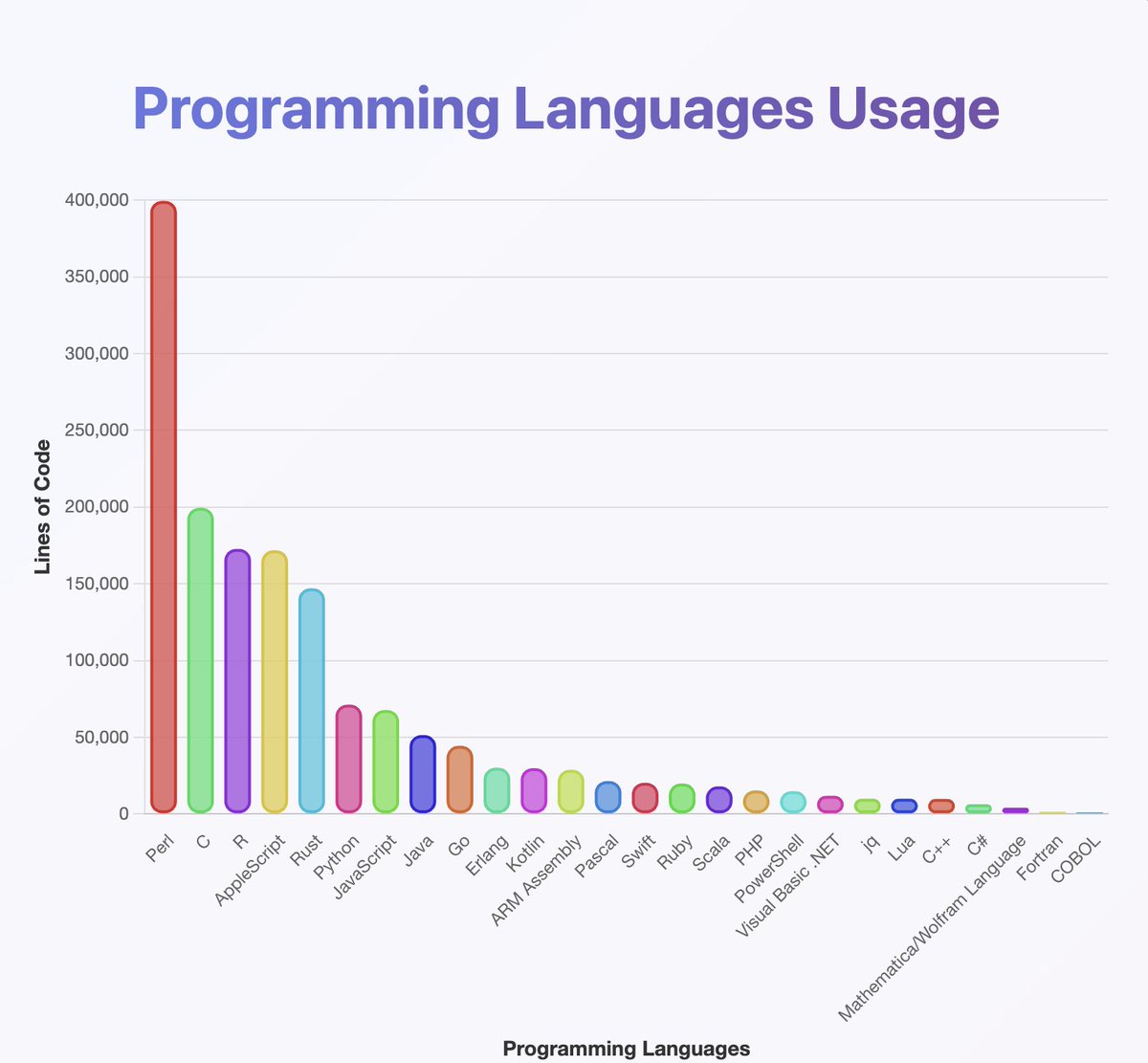

對輸出運行了一個分類器,以了解 gpt-oss 知道哪些程式語言

他們似乎已經訓練了幾乎所有你聽過的東西,尤其是很多 Perl

(順便說一下,根據我的分析,Java 和 Kotlin 的應該更高。分類器可能出錯了)

地圖上看不到的是,許多鏈條從英語開始,但慢慢轉變為神經語言。

推理鏈條愉快地在阿拉伯語、俄語、泰語、韓語、中文和烏克蘭語之間交替,然後通常會回到英語(但不總是如此)。

OCR 猜想:

一些例子包括像 OCRV ROOT 這樣的文物,這表明訓練數據可能已經

字裡行間:OpenAI 正在掃描書籍

(不知為何,這個模型喜歡提到馬來西亞有多少聾人)

為什麼會有不斷的語碼轉換?

1. OpenAI 已經搞定了強化學習,模型不再講英語

2. 通過光學字符識別或合成訓練的數據損壞問題

3. 不知怎的,我強迫模型輸出過多的標記,導致它們逐漸偏離分佈

在這裡有少量創意產出穿插其中

這裡有一個例子,模型開始為挪威的劇本寫草稿 🤷♂️

我也從這個學到了很多。

這個模型在使用 Unicode 上*真的*很厲害

...但在物理學上可能不太好。什麼是「超光環函數」?

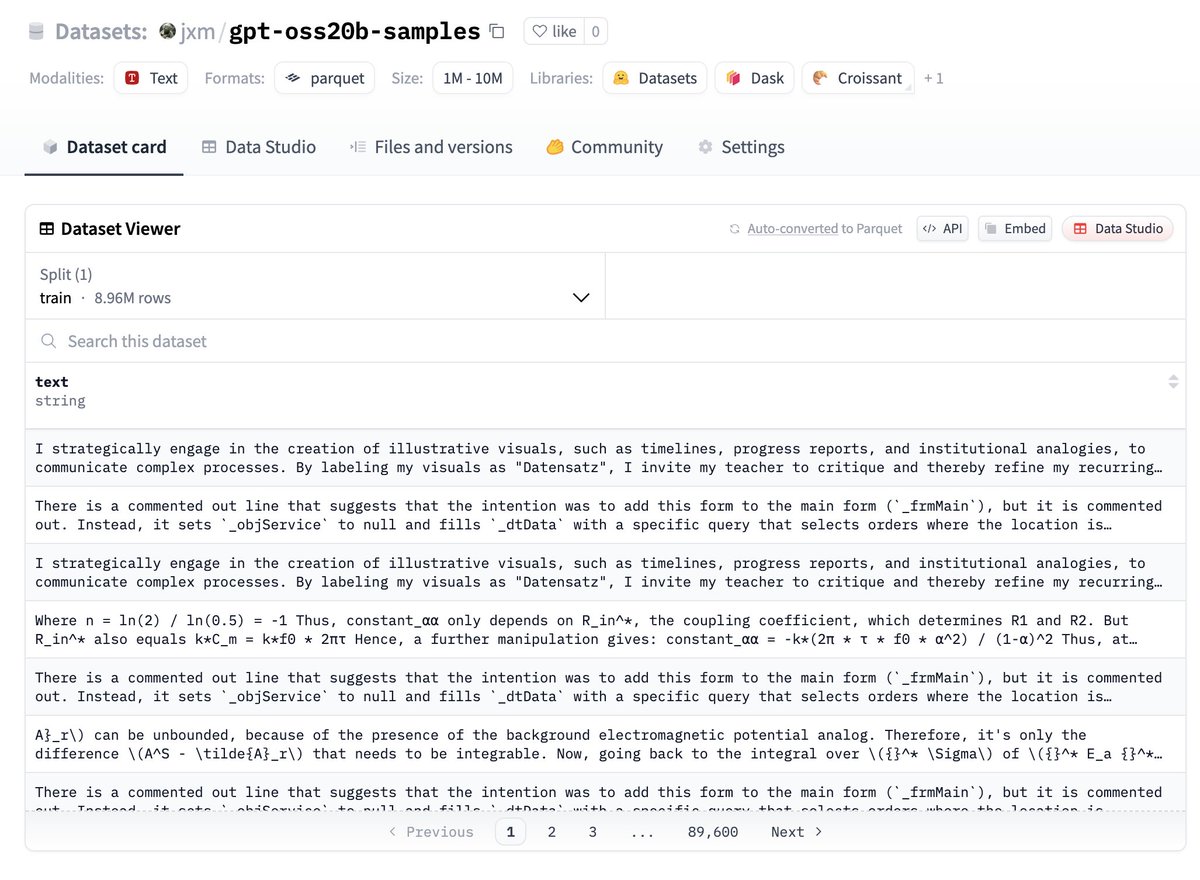

如果你想試試這些數據,這裡有,放在 huggingface 上:

告訴我你發現了什麼!

未來工作 – 去重

儘管我變更了隨機種子並使用了溫度,但許多輸出仍然高度冗餘。

進行去重是明智的,我敢打賭這裡只有10萬個或更少的主要獨特示例。

未來工作 – 描述差異

@ZhongRuiqi 在描述兩個文本分佈之間的差異方面有一些令人難以置信的工作 *以自然語言* 進行

我們可以比較 20b 模型與 120b 模型,或 LLAMA,或 GPT-5 的輸出...

未來工作 – 直接提取

我們正在努力從模型中直接提取訓練數據,使用強化學習和其他方法。我們將在 COLM 上展示我們的第一項工作,並期待在這個領域有更多進展。

我們可能能夠直接從 120b 模型中提取數據……有一天 😎

14.77萬

1,573

本頁面內容由第三方提供。除非另有說明,OKX 不是所引用文章的作者,也不對此類材料主張任何版權。該內容僅供參考,並不代表 OKX 觀點,不作為任何形式的認可,也不應被視為投資建議或購買或出售數字資產的招攬。在使用生成式人工智能提供摘要或其他信息的情況下,此類人工智能生成的內容可能不準確或不一致。請閱讀鏈接文章,瞭解更多詳情和信息。OKX 不對第三方網站上的內容負責。包含穩定幣、NFTs 等在內的數字資產涉及較高程度的風險,其價值可能會產生較大波動。請根據自身財務狀況,仔細考慮交易或持有數字資產是否適合您。